Eric Lopes Cardozo

Recentelijk is bijvoorbeeld de directie van OpenAI, het bedrijf achter ChatGPT, bestookt met vragen over hoe ze de $ 1,4 biljoen aan dit jaar opgebouwde datacenteruitbreidingen en gebruiksverplichtingen denken te gaan terugbetalen. Dit aangezien alleen de rentelast al hoger is dan de jaarlijkse inkomsten. Sarah Friar, OpenAI’s CFO, had aanvankelijk geantwoord dat de Amerikaanse overheid garant zou moeten gaan staan om lage rentes en de toepassing van de nieuwste en beste computerchips te bewerkstelligen. OpenAI’s bedrijfsrisico wordt daarmee afgewenteld op de Amerikaanse belastingbetaler. Hoewel ze later die dag op deze uitspraak moest terugkomen, is het duidelijk hoe het er bij hen financieel voorstaat. Een ongekende hoeveelheid aan financiële middelen wordt geïnvesteerd in één specifieke branche met een dubieus businessmodel, dat eigendom is van een selecte groep too big to fail-bedrijven, hetgeen doet denken aan de bankencrisis van 2008.

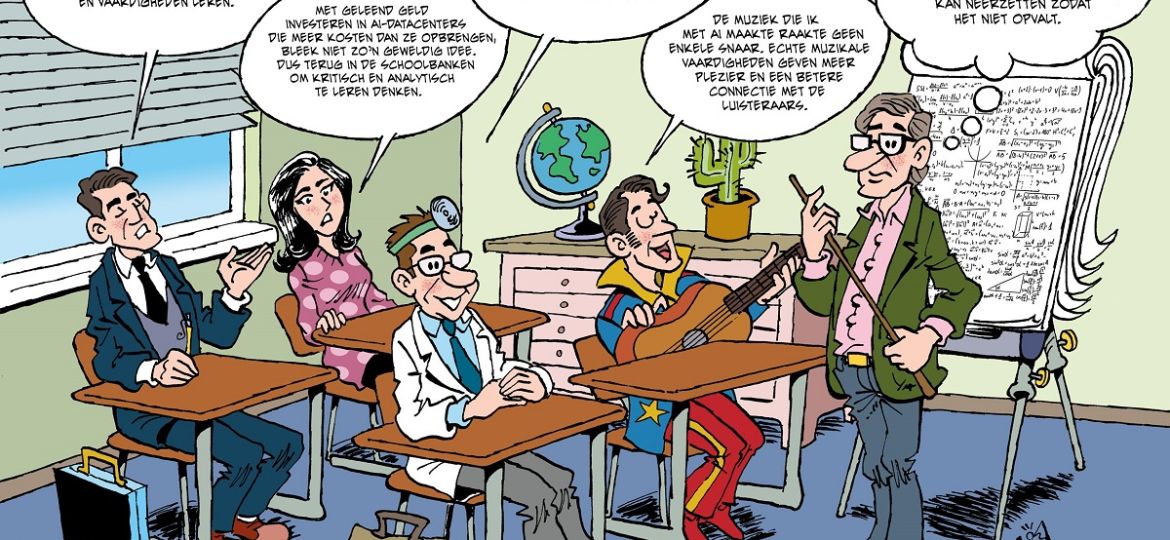

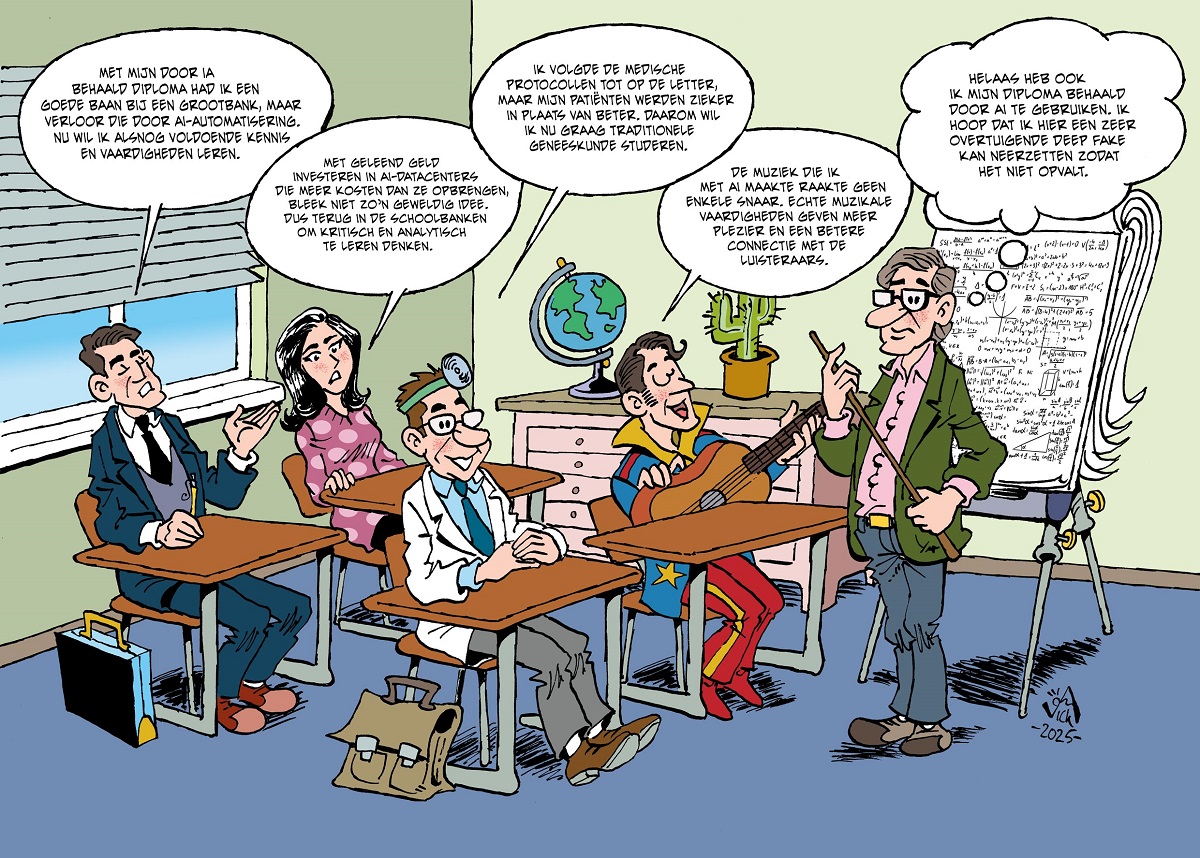

Er zijn naast indirecte financiële risico’s en verlies van banen nog andere effecten van economische aard. Datacentra verbruiken bijvoorbeeld dusdanig veel elektriciteit en koelwater dat de vraag inmiddels het aanbod overtreft, hetgeen weer leidt tot hogere kosten, ook voor de bevolking, voor elektriciteit en water. Geld dat nodig is voor de bouw van datacentra onttrekt verder middelen die ook hadden kunnen worden gebruikt voor andere doeleinden, zoals bijvoorbeeld het bouwen van huizen. Het inmiddels wijdverbreide gebruik van AI heeft verder sterke negatieve gevolgen binnen het onderwijs. Studenten die bijvoorbeeld essays laten schrijven door AI, hoeven nooit boeken te lezen, of de benodigde materie goed te doorgronden. Grammaticale kennis is ook niet nodig, want ook dat wordt ze door AI uit handen genomen.

Dat er inmiddels sprake is van een AI bubble werd ook bevestigd door Sundar Pichai, CEO van Alphabet, de moedermaatschappij van onder meer Google en YouTube. Tijdens een recent interview met de BBC waarschuwde hij voor de economische risico’s ten gevolge van een overmaat aan investeringen en irrationele verwachtingen over de opbrengsten. Pichai ging nog verder door ook te waarschuwen dat de huidige snelle groei van kunstmatige intelligentie tot grote maatschappelijke ontwrichtingen zal leiden. Dit vooral door veranderingen en verschuivingen op het gebied van werk en een (te) blind vertrouwen op de antwoorden en uitkomsten van AI. Ook benoemde hij het probleem van het schenden van intellectueel eigendom, bij zowel het inleren van AI als het zonder toestemming gebruiken ervan, zoals bijvoorbeeld bij het door AI laten genereren van muziek.

In zijn rol als CEO kon Pichai niet anders dan ook de positieve kanten van AI belichten. Zo stelde hij dat de immense vraag naar energie niet ten koste hoeft te gaan van het behalen van de klimaatdoelstellingen. De oplossing zou dan moeten komen van ontwikkelingen op het gebied van kernenergie, geothermie en kernfusie. Ook stelde hij dat AI binnen twaalf maanden in staat is om meer complexe taken uit te voeren, zoals bijvoorbeeld het direct bestellen van een cadeau op basis van een geformuleerde behoefte (agent-technologie). Pichai verwijst hiermee naar een ophanden zijnde convergentie van verschillende technologische ontwikkelingen. Dit betreft de volgende evolutie van AI, namelijk Artificial General Intelligence (AGI). AI verlaat hiermee het niveau van een geavanceerde zoekmachine. Bij AGI is er sprake van zelflerend en probleemoplossend vermogen. Andere technologische ontwikkelen zijn die van de robotica, kwantumcomputers en (decentrale) energieopwekking middels fusietechnologie en LENR (Low Energy Nuclear Reactions). Met reeds voorhanden zijnde technologieën als CRISPR, het printen van organen en synthetische biologie ontstaat er een combinatie van ontwikkelingen die in potentie zou kunnen leiden tot de ontwikkeling van een artificieel ‘organisme’ dat de mens op tal van fronten voorbij kan streven. Dit risico werd echter tijdens het interview niet besproken.

Het bevragen van ChatGPT over de risico’s van AI, levert als reactie een valide set aan risico’s op. Zo benoemt het de kwaliteit van de huidige generatie AI-modellen die betrouwbaar lijken, maar volledig foutieve resultaten kunnen opleveren. Ook benoemde het de kans op misleiding, omdat het zeer eenvoudig is geworden om zogenaamde deepfakes te vervaardigen, waarmee echte gebeurtenissen nog nauwelijks kunnen worden onderscheiden van kunstmatig samengestelde. Verder benoemt het de risico’s van het sturen van de publieke opinie, de totstandbrenging van een op protocollen gebaseerde samenleving, machtsconcentratie en machtsverschuiving. Het stelt dat wie de data beheert ook het narratief beheert, en dit zal dan zijn voorbehouden aan een klein aantal bedrijven en staten die beschikken over de hiervoor benodigde financiële middelen. Het benoemt daarmee de mogelijke totstandbrenging van een informatiemonopolie, dat het publieke domein kan beïnvloeden zonder enige vorm van controle.

Het risico op een informatiemonopolie binnen de wetenschap en de medische wereld is heel reëel. Dit komt doordat AI geen onderscheid kan maken tussen een door onafhankelijke wetenschappers geschreven publicatie en een frauduleus onderzoeksresultaat, of tussen een legitiem medisch artikel en marketing van een farmaceutisch bedrijf. Zelfs de meeste artsen weten vaak al niet meer of ze te maken hebben met een legitiem artikel over een bepaald onderzoek, of een door Big Pharma gesubsidieerde publicatie die louter tot doel heeft artsen ertoe aan te zetten bepaalde medicijnen voor te schrijven. Aangezien dit soort artikelen ook worden gepubliceerd in prestigieuze medische tijdschriften, is het onvermijdelijk dat AI ook zal worden gevoed met ondeugdelijke – zo niet frauduleuze – informatie. Wanneer AI wordt gebruikt voor bijvoorbeeld het ontwerpen van medische protocollen, zijn de gevolgen niet te overzien. Dat artsen worden gedwongen klakkeloos protocollen te volgen, zelfs wanneer die ondeugdelijk of zelfs levensgevaarlijk zijn, is overduidelijk geworden tijdens de georkestreerde Covid-‘pandemie’. Dit vond al plaats voorafgaand aan de indertijd door AI vastgestelde medische protocollen. Een door AI versterkte teloorgang van onderwijs, waaronder die van artsen, maakt de kans op allerlei vormen van ellende alleen maar groter. Dat AI ook een plaats gaat krijgen in de zorg is geen toekomstmuziek. In de VS is thans het wetsvoorstel Healthy Technology Act 2025 in behandeling bij het Congres. Het zou AI-systemen toestaan medicijnen voor te schrijven zonder tussenkomst van een arts. De Amerikaanse Food and Drug Administration (FDA) heeft inmiddels al meer dan duizend AI-tools goedgekeurd, zij het meestal voor beperkte en goed gedefinieerde taken.

Het toenemend stellen van vragen over de kosten en baten van AI duidt op de ontwikkeling van een tegenkracht. Een ander signaal hiervoor is dat bedrijven hun intellectuele eigendommen trachten te beschermen door zich te beperken tot één specifiek type AI, zoals bijvoorbeeld Microsofts Copilot. Vervolgstappen zijn dan het opzetten van een eigen lokale AI, waarmee de ongecontroleerde verspreiding van de eigen informatie wordt beperkt. Ook gaat men over tot het ontwikkelen van eigen taalmodellen ter verbetering van de taalkundige kwaliteit van de zoekresultaten of gegenereerde uitkomsten.

Ook in de muziekwereld lijkt er een tegenbeweging op komst. Het NRC wist te melden dat de Franse muziekstreamingdienst Deezer heeft ontdekt dat ruim een derde van alle nieuwe muziek inmiddels met behulp van AI wordt gecreëerd. Het betreft zo’n 50.000 nummers per dag. Bij Deezer begrijpt men dat muzikanten hiermee op twee manieren worden benadeeld: zowel door het onbetaalde gebruik van oorspronkelijk werk als door het afromen van mogelijke opbrengsten vanuit de streamingsdiensten. Sinds juni dit jaar voorziet Deezer daarom met AI gegenereerde muziek van een label, zodat de herkomst ervan voor de luisteraar duidelijk is. Het blijkt dat luisteraars graag een connectie willen kunnen maken met de artiest en dat is bij AI logischerwijs niet mogelijk.

Ook in het onderwijs begint men langzaamaan te beseffen dat men studenten moet leren hoe om te gaan met AI. Studenten moeten worden verplicht om daadwerkelijk zelf kennis en vaardigheden op te doen. Hierbij zijn vaardigheden als kritisch en analytisch denken, informatieverwerking, een goede taalbeheersing, presentatie en reflecteren op het eigen leerproces essentieel.

– einde artikel –

Je las een Premium artikel uit Gezond Verstand

Volg ons op social media

Kijk en beluister Gezond Verstand via